Pytorch模型转换成GPU模型出现错误

因为目前还没有PyTorch标签,所以就用了TensorFlow了,麻烦盛誉值高的大大加上这个标签好吗,Thanks♪(・ω・)ノ

我最近准备使用VGG模型来训练数据,然后想用GPU,但是在将VGG模型转化成VGG.cuda()时老是报错,我刚开始以为是数据集的问题,但是后来我啥都没弄直接先将VGG转化成.cuda()形式,但也还是报错,代码和报错情况如下:

回答:

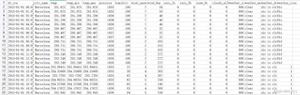

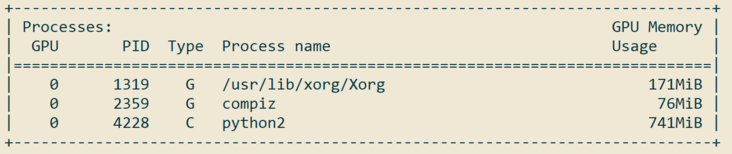

提示是out of memory,是不是显存不够呢?我试了一下,pytorch 0.3.1 + torchvision 0.2.0加载VGG16要700多MB显存:

可以先试一下小一点的模型或者看看是不是cuda有问题。

以上是 Pytorch模型转换成GPU模型出现错误 的全部内容, 来源链接: utcz.com/a/156913.html