urllib.urlretrieve 下载 pdf 死循环

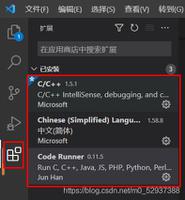

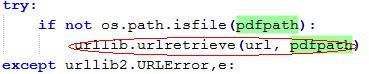

使用 urllib.urlretrieve 下载一个网站的 pdf ,代码如下:

试了好几次,每次到下载 4000 多个 pdf 的时候,就会卡死在 urlretrieve 里面出不来

请问:是不是 urlretrieve 把网络资源给消耗光了,接收不到数据了?

回答:

我之前写爬虫遇到下面的坑,看能不能帮助你:

如果是多线程或者多进程,仔细调试防止死锁

设置

timemout,看看是不是网络延迟。如果单位时间内保持的链接太多,服务器可能会强制断开链接,或者造成网络拥塞不要这样保存文件,这样打开文件太多,请使用队列

使用

traceback看看异常信息

以上是 urllib.urlretrieve 下载 pdf 死循环 的全部内容, 来源链接: utcz.com/a/156817.html