poi利用sax解析百万数据Excel的JVM内存占用问题?

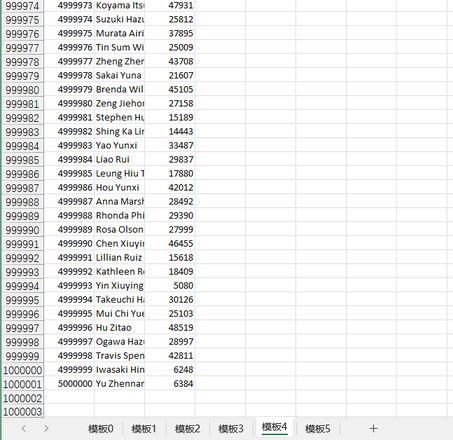

Excel中有500W数据,使用poi的sax模式逐行读取,然后批量插入到数据库。

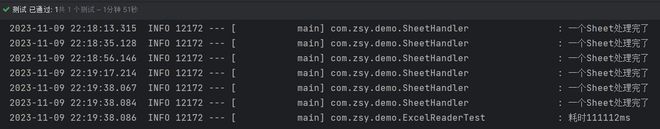

测试代码未改动,仅设置JVM内存参数。

第一次不改动JVM,导入500W数据到数据库

耗时1分51秒

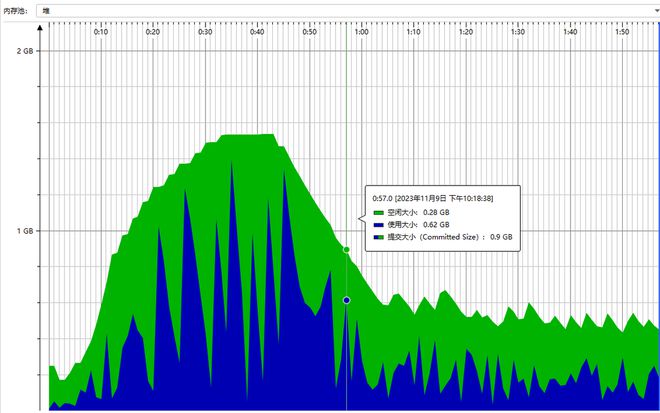

内存占用如下

第二次JVM内存最大、最小参数都设置为500M,此时耗时1分43秒,内存占用更是平均只有140MB!!

我已经凌乱了,到底是为什么呢?JVM内存设置的小了,占用的内存也跟着小了,而且时间上还相差无几,导入到数据库的效果也是一样成功。。

回答:

纯猜测:对于楼主的场景,大堆扩容消耗的时间,比小堆频繁 gc 的时间长。没了

其实还有一种可能:jvm 上执行代码耗时接近,但是第二次数据库那边状态更好于是就更快乐

结合楼主之前的两个问题 问题一 问题二,提一些事情:

- 还是老问题,测试次数太少了,就一次的数据不能说明问题,起码重复个十次再说。测试方式也不严谨,插数据库这个动作对测试结果的影响最大同时很不稳定且基本无法控制

- 建议楼主学习一下 jvm 内存管理的相关知识,了解一下 吞吐量响应时间的取舍,大堆小堆的性能特性还有其他的一堆巴拉巴拉

以上是 poi利用sax解析百万数据Excel的JVM内存占用问题? 的全部内容, 来源链接: utcz.com/p/945415.html