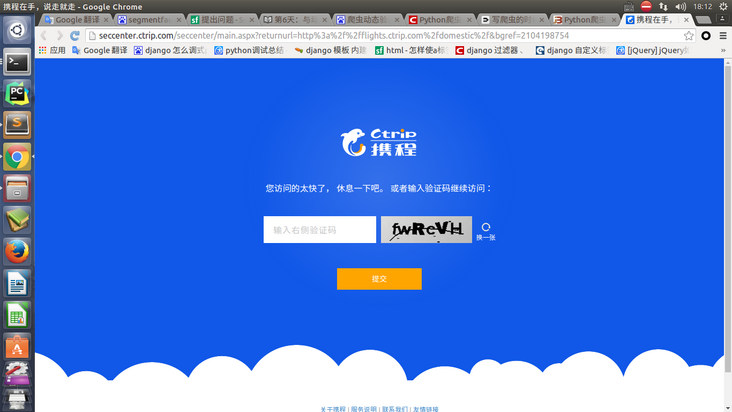

scrapy 在爬取携程时,被重定向到了一个有验证码的页面怎么办?

回答:

降低你的爬去频率,或者使用多IP 代理。

回答:

如果验证码比较复杂的话,可以使用各种打码平台提供的验证码识别API(可能收费)。

比较简单的可以使用pytesseract库进行识别(可参考https://www.waitalone.cn/pyth...)。

主要思路就是将验证码下载下来,注意保存cookie或session,然后识别验证码,提交结果带上相关cookie或session。

想要减少验证的次数可以试着更换代理IP,设置爬虫间隔,更换User-Agent等操作。

以上是 scrapy 在爬取携程时,被重定向到了一个有验证码的页面怎么办? 的全部内容, 来源链接: utcz.com/a/158659.html