发现一个好网站,人间尤物、魅惑黑丝都是福利呀!那就都爬取下来

前言

本文的文字及图片来源于网络,仅供学习、交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理。

今天发现一个好网站

https://www.mzitu.com/

先来欣赏一下爬下来的图片

咳咳。。。不知道能不能过

学习之余我们来练习一下代码

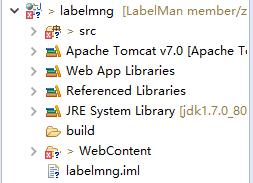

开发工具

- python 3.6.5

- pycharm

爬虫代码

导入工具

import requestsimport parsel

请求网页获取列表页

response = requests.get(url=url, headers=headers)selector

= parsel.Selector(response.text)lis

= selector.css("#pins li a::attr(href)").getall()for li in lis:page_id

= li.split("/")[-1]

获取详情页下一页url

def netx_url(url, page_id):response_2

= requests.get(url=url, headers=headers)selector

= parsel.Selector(response_2.text)last_num

= selector.css(".pagenavi a:nth-child(7) span::text").get()for i in range(1, int(last_num) + 1):new_url

= "https://www.mzitu.com/{}/{}".format(page_id, i)

保存数据

def download(url):response

= requests.get(url=url, headers=headers)selector

= parsel.Selector(response.text)title

= selector.css("body > div.main > div.content > h2::text").get() # 图片标题img_url = selector.css(".main-image p img::attr(src)").get() # 图片地址

path = "D:pythondemo妹子图img" + title + ".jpg"

download_response = requests.get(url=img_url, headers=headers)

with open(path, mode="wb") as f:

f.write(download_response.content)

print(title, img_url)

运行代码,效果如下图

以上是 发现一个好网站,人间尤物、魅惑黑丝都是福利呀!那就都爬取下来 的全部内容, 来源链接: utcz.com/z/531192.html