Python爬虫练习:爬取赶集网数据信息

本文的文字及图片来源于网络,仅供学习、交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理。

以下文章来源于云+社区,作者 py3study

转载地址

https://blog.csdn.net/fei347795790?t=1

一.创建项目

scrapy startproject putu

二.创建spider文件

scrapy genspider patubole patubole.com

三.利用chrome浏览器分析出房价和标题的两个字段的xpath表达式,开始编写patubole.py文件。网络的爬取是通过这个文件进行的

以下代码是最终的代码

所建的patubole.py文件必须实现name,parse函数,start_url这三个属性

四.将爬取的数据保存到数据库sufang中。

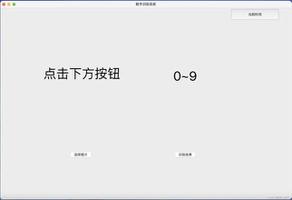

(1)在pycharm中新建数据库

完成后会出现

(2)将数据存放在新建的数据库zufang的数据表sufang中

数据的爬取是由patubole.py实现的,数据的存储是由pipelines.py实现的,pipelines.py又是有items.py提供数据的支持

所以编写items.py

此时就要回过头来修改刚开始为了测试编写的patubole.py 文件

代码如下

3)在settings.py中进行PatuPipeline文件配置

ITEM_PIPELINES = {

"patu.pipelines.PatuPipeline": 300,

}

(5)pipelines.py文件代码,实现存储数据到数据库中

其中包含SQL的相关知识

最终结果

其中main.py文件是为了调试方便而添加的,可以不用,直接用相关命令启动爬虫

以上是 Python爬虫练习:爬取赶集网数据信息 的全部内容, 来源链接: utcz.com/z/530989.html