Python反反爬虫实战,JS解密入门案例,详解调用有道翻译

文章目录

- 前言

- 分析

- 分析url分析参数01分析参数02加密分析

- 模拟请求

- 注意点请求代码执行结果

- 结语

很多人学习python,不知道从何学起。

很多人学习python,掌握了基本语法过后,不知道在哪里寻找案例上手。

很多已经做案例的人,却不知道如何去学习更加高深的知识。

那么针对这三类人,我给大家提供一个好的学习平台,免费领取视频教程,电子书籍,以及课程的源代码!??¤

QQ群:623406465

前言

其实在以前就盯上有道翻译了的,但是由于时间问题一直没有研究(我的骚操作还在后面,记得关注),本文主要讲解如何用python调用有道翻译,讲解这个爬虫与有道翻译的js“斗争”的过程!

当然,本文仅供交流学习使用,适合自己做一些小东西娱乐,禁止用于商业用途!转载请注明微信公众号:bigsai。项目github地址:https://github.com/javasmall/python

分析

对于一个网站,首先肯定要的就是分析,分析其中的网页规则

分析url

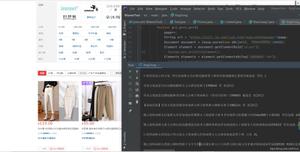

进入有道翻译你会发现它的url是没有变化的,也就是说它的请求是通过ajax异步交互的。点击F12,很容易在XHR中找到这个交互的请求,点击查看信息,你会发现一串参数,其中有几个还是加密了的,啥salt盐啥的。先有个数。

分析参数01

可以大胆猜测:这个关键参数肯定在一块。我们搜索salt,然后正常的点击,格式化展开,在js中再次搜索salt。想找相关salt附近看看能不能找到断点进行调试!当然,最终你可以找到11个相关内容可以在每个附近进行断点调试。你这样乐意找到相关位置关键加密字段和函数。

分析参数02

这次,咱们使用浏览器调用堆栈的功能,查看js执行的堆栈进行查找。直接点击到对应模块打断点即可进行观察。最终你会找到这个位置generateSaltSign(n)的这个函数,主要加密函数都在里面执行

加密分析

其实有道翻译的加密是比较简单的了,你一看,

- 不知道navigator.appVersion是啥是吧,我打印一看。就是浏览器头进行md5加密的嘛,可以固定不变的,也就是说这个bv(t)参数它可以是固定不变的。

- 这个ts不就是13位当前时间戳吗!

- 这个salt不就是时间戳后面加上100内的随机数吗,随便取一个就行。

- 这个sign不就是"fanyideskweb" + 翻译的字符串 + salt + "n%A-rKaT5fb[Gy?;N5@Tj"这么一串串数字然后md5加密的嘛!

通过后面的分析发现这些参数并没有变化。所以这次生成的是唯一的,但是有一个前提是5000字以内,如果超出5000字他会截取前5000字,这点需要注意一下。

模拟请求

注意点

既然有了上面的规则,那么咱们就可以通过这部分的规则和抓包的信息整合用python模拟完成js的事件,发送请求。这里面有几点需要注意的。

Fristly,你要搞定python中md5加密模块,时间time模块,能够做出一些等价的一些转化。刚好,py的hashlib和time模块 can fullfill 你。这个问题解决。

In addition,post请求的主体data字典需要进行url编码才能当成data发送请求发过去。

last but not least,解决完加密最重要的就是header,大家一定不要麻批大意。这个content—length,经过我的经验告诉我它如果填错了就会报错,并且不填经过抓包分析系统会自动生成。所以不要计算主体长度的,这个参数一定要省略。不放cookie会报错,放了cookie经过测试你会发现有些可以该甚至可有可无,有些必须遵从其样式。而cookie中必须遵从的就是OUTFOX_SEARCH_USER_ID=-1053218418@117.136.67.240即数字+@+ip形式地址。可能是为了检验而用,这个可以直接进行模拟。

请求代码

返回结果是一串json,直接拿即可!

import requestsimport hashlib

import time

import urllib.parse

# 创建md5对象

def nmd5(str):

m

= hashlib.md5()# Tips

# 此处必须encode

# 若写法为m.update(str) 报错为: Unicode

-objects must be encoded before hashing# 因为python3里默认的str是unicode

# 或者 b

= bytes(str, encoding="utf-8"),作用相同,都是encode为bytesb

= str.encode(encoding="utf-8")m.update(b)

str_md5

= m.hexdigest()return str_md5def formdata(transtr):

# 待加密信息

headerstr

= "5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.86 Safari/537.36"#print(round(time.time()

*1000))bv

=nmd5(headerstr)ts

=str(round(time.time()*1000))salt

=ts+"90"strexample

="fanyideskweb"+transtr+salt+"n%A-rKaT5fb[Gy?;N5@Tj"sign

=nmd5(strexample)#print(sign)

i

=len(transtr)#print(i)

# print(

"MD5加密前为 :" + headerstr)# print(

"MD5加密后为 :" + bv)dict

={"i":transtr,"from":"AUTO","TO":"AUTO","smartresult": "dict","client":"fanyideskweb","salt":salt,"sign":sign,"ts":ts,"bv":bv,"doctype":"json","version":"2.1","keyfrom":"fanyi.web","action":"FY_BY_REALTlME"}

return dicturl

="http://fanyi.youdao.com/translate_o?smartresult=dict&smartresult=rule"header

={"User-Agent":"Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.86 Safari/537.36","Referer":"http://fanyi.youdao.com/","Origin": "http://fanyi.youdao.com","Content-Type":"application/x-www-form-urlencoded; charset=UTF-8","X-Requested-With":"XMLHttpRequest","Accept":"application/json, text/javascript, */*; q=0.01","Accept-Encoding":"gzip, deflate","Accept-Language":"zh-CN,zh;q=0.9","Connection": "keep-alive","Host": "fanyi.youdao.com","cookie":"_ntes_nnid=937f1c788f1e087cf91d616319dc536a,1564395185984; OUTFOX_SEARCH_USER_ID_NCOO=; OUTFOX_SEARCH_USER_ID=-10218418@11.136.67.24; JSESSIONID=; ___rl__test__cookies=1"}

input

=input("请输入翻译内容:")dict

=formdata(input)dict

=urllib.parse.urlencode(dict)dict

=str(dict)#dict

=urllib.parse.urlencode(dict).encode("utf-8")req

=requests.post(url,data=dict,headers=header)val

=req.json()print(val[

"translateResult"][0][0]["tgt"])

执行结果

结语

就这样,我们从0开始优雅的揭开有道翻译的面纱!你可以利用这个做一些有趣的事情(待续------)

以上是 Python反反爬虫实战,JS解密入门案例,详解调用有道翻译 的全部内容, 来源链接: utcz.com/z/530779.html