Python爬虫JS案例分析:爬取鬼灭之刃漫

本文的文字及图片来源于网络,仅供学习、交流使用,不具有任何商业用途,如有问题请及时联系我们以作处理。

文章转载于公众号:快学Python

作者:皖渝

猪油骨,拿来卤~今天,来分享一下python图片爬取+简单JS分析

爬取网址:漫画地址(这个网站只更新到188话,实际上已经有200多话了)

一、获取所有章节URL地址

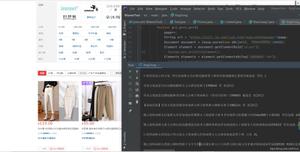

打开网址后,使用Chrome抓包,发现所有章节的数据如下所示:

def get_html(url):r=requests.get(url,headers=header)

r.encoding="gbk"

if r.status_code==200:

return r.text

except:

print("网络连接异常")

def get_total_chapter():

data=json.loads(get_html(url))

chapter_total=data["Comics"][2]["Chapters"]

for item in chapter_total:

yield item.get("Url")

二、解析图片地址,进行简单JS解密

点击进入第一话后,分析网页源码,发现图片保存在a标签下的img中,但是需要爬取的src是用javascript写的!这个时候直接用lxml库去解析是拿不到图片的。

这里,我们先分析图片链接的组成,用正则把提取出来即可。

src=""+m201304d+"newkuku/2016/02/15/鬼灭之刃][第1话/JOJO_001513.jpg"

其中,m201304是加密的部分,这个网站比较简单,直接找到js4.js文件,即可发现m201304对应的是http://v2.kukudm.com/,除此之外还有三个加密码,我们可以构建成列表,用if判断是否含如下加密码,再用replace替换即可。

三、翻页分析

分析URL可知,第一话共54页,通过改变末尾的/number.html即可实现翻页

全部代码

所有图片都放在桌面的comic文件夹下

import requestsimport json

import os

import re

import time

os.chdir("C:/Users/dell/Desktop/comic")

url="https://api.soman.com/soman.ashx?action=getsomancomicdetail&comicname=%E9%AC%BC%E7%81%AD%E4%B9%8B%E5%88%83&source=kuku%E5%8A%A8%E6%BC%AB"

header={"user-agent":"Opera/9.80 (Windows NT 6.0; U; en) Presto/2.8.99 Version/11.10"}

def get_html(url):

r=requests.get(url,headers=header,timeout=5)

r.encoding="gbk"

if r.status_code==200:

return r.text

else:

print("网络连接异常")

def get_total_chapter():

data=json.loads(get_html(url))

chapter_total=data["Comics"][2]["Chapters"]

for item in chapter_total:

yield item.get("Url")

def save_items(url,count):

r=requests.get(url,headers=header,timeout=5)

with open("./第{}话/".format(count)+str(int(time.time()))+".jpg","wb") as f:

f.write(r.content)

def get_all_img(): #得到每话总图片数

src_list=["m200911d","m201001d","m201304d","k0910k"]

count=0

for chapter in get_total_chapter():

try:

count+=1

os.makedirs("./第{}话".format(count))

pat="共(.*?)页"

total_page=re.search(pat,get_html(chapter)).group(1)

for page in range(1,int(total_page)+1):

pat1="<IMG SRC=(.*)></a>"

src=re.search(pat1,get_html(chapter)).group(1)

for item in src_list:

if item in src_list:

src=src.replace("+"+item+"+","http://v2.kukudm.com/").replace(""","")

save_items(eval(src),count)

print("第{}话第{}页爬取完成".format(count,page))

now_page=re.search(".*/(.*).htm",chapter).group(1)

chapter=chapter.replace(str(now_page)+".htm",str(page+1)+".htm")

except:

print("未爬取到数据")

if __name__=="__main__":

get_all_img()

最终爬取的漫画如下(这里仅作示例,只爬取了前10话的内容):

以上是 Python爬虫JS案例分析:爬取鬼灭之刃漫 的全部内容, 来源链接: utcz.com/z/530126.html