Linux切割大文件

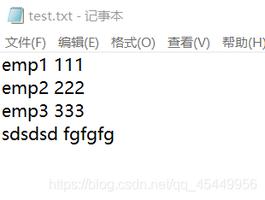

最近发现一个老的项目,就一个日志文件,没有按天划分,并采用追加的方式,已经记录了大半年的日志,50G,这种很显然需要切割才能方便查询。

解决方案

1.如果是查询最近的日志,可以用tail 命令,例如下面,查询error.log的最后一千行

tail -n1000 error.log

2.如果是查询最早的日志,可以用head命令,例如下面,查询error.log的最后一千行

head -n1000 error.log

3.如果无法确定行数, 可以采用切分大文件, 例如下面,将error.log拆成每个文件十万行

split -l100000 error.log -d-a4 error.log-a 4: 后缀系数为四位数

-d:使用数字作为后缀

-l:每一输出档的列数大小

以上是 Linux切割大文件 的全部内容, 来源链接: utcz.com/z/512852.html