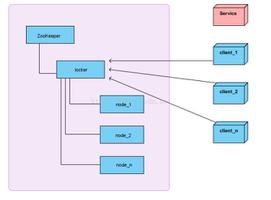

scrapy-redis 分布式里面的 多台机器分布url问题

Slave端:scrapy runspider juzi.py

Master端:

redis-cli > lpush itjuzispider:start_urls http://www.itjuzi.com/company

一个链接我可以lpush 但是假如一个网站有几万页,我想多台机器爬取,这样如何把这几万页分给几个不同的机器呢?总不能人一个个的push吧

回答:

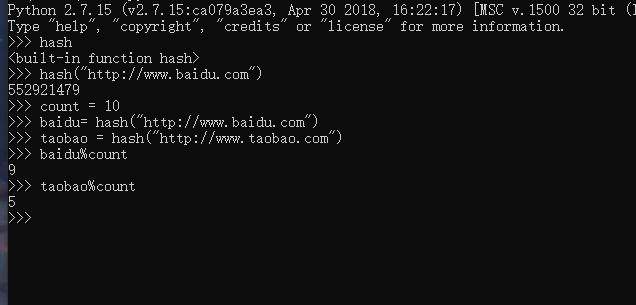

- url获取与一个hash值 % 机器数量

- 电脑数量轮询

权重随机 每一个机器设置一个权重

{"机器1":0.2,

"机器2":0.6

}

生成一个0-1随机数假设0.1,那么交给机器1处理.....

JAVA 实现

https://github.com/huifer/jav...

以上是 scrapy-redis 分布式里面的 多台机器分布url问题 的全部内容, 来源链接: utcz.com/p/937624.html