【Python】Scrapy 豆瓣搜索页爬虫

Scrapy 豆瓣搜索页爬虫

使用scrapy爬虫框架对豆瓣图书搜索结果进行爬取

Scrapy

Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架

可以应用在包括数据挖掘,信息处理或存储历史数据等一系列的程序

它提供了多种类型爬虫的基类,如BaseSpider、CrawlSpider等

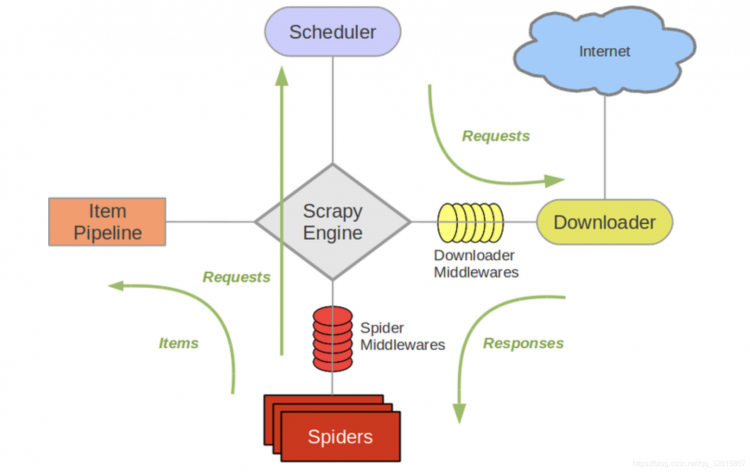

主要组件

Scrapy框架主要由五大组件组成

调度器(Scheduler)

调度器,说白了把它假设成为一个URL的优先队列,由它来决定下一个要抓取的网址是什么,同时去除重复的网址,用户可以自己的需求定制调度器。下载器(Downloader)

下载器,是所有组件中负担最大的,它用于高速地下载网络上的资源

Scrapy的下载器代码不会太复杂,但效率高,主要的原因是Scrapy下载器是建立在twisted这个高效的 异步模型上的爬虫(Spider)

爬虫,是用户最关心的部份。用户定制自己的爬虫(通过定制正则表达式等语法),用于从特定的网页中提取自己需要的信息,即所谓的实体(Item)。 用户也可以从中提取出链接,让Scrapy继续抓取下一个页面

实体管道(Item Pipeline)

实体管道,用于处理爬虫(spider)提取的实体(Item)

主要的功能是持久化实体、验证实体的有效性、清除不需要的信息

Scrapy引擎(Scrapy Engine)

Scrapy引擎是整个框架的核心

它用来控制调试器、下载器、爬虫。实际上,引擎相当于计算机的CPU,它控制着整个流程

数据流(Data flow)

Scrapy中的数据流由执行引擎控制,其过程如下:

- 引擎打开一个网站,找到处理该网站的Spider并向该spider请求第一个要爬取的URL(s)

- 引擎从Spider中获取到第一个要爬取的URL并在调度器(Scheduler)以Request调度

- 引擎向调度器请求下一个要爬取的URL

- 调度器返回下一个要爬取的URL给引擎,引擎将URL通过下载中间件(request方向)转发给下载器(Downloader)

- 一旦页面下载完毕,下载器生成一个该页面的Response,并将其通过下载中间件(response方向)发送给引擎

- 引擎从下载器中接收到Response并通过Spider中间件(输入方向)发送给Spider处理

- Spider处理Response并返回爬取到的Item及(跟进的)新的Request给引擎

- 引擎将(Spider返回的)爬取到的Item给Item Pipeline,将(Spider返回的)Request给调度器

- (从第二步)重复直到调度器中没有更多地request,引擎关闭该网站

简单使用

scrapy项目目录结构

通过命令scrapy startproject tutorial创建一个新的项目tutorial

将会创建包含下列内容的 tutorial 目录

python">tutorial/scrapy.cfg # 项目的配置文件

tutorial/ # 该项目的python模块之后将在此加入代码

__init__.py

items.py # 项目中的item文件

pipelines.py # 项目中的pipelines文件

settings.py # 项目的设置文件

spiders/ # 放置spider代码的目录

__init__.py

...

使用scrapy爬取豆瓣搜索页

分析

https://search.douban.com/movie/subject_search?search_text={search_text}&cat=1002&start={start}

search_text 搜索关键字

cat 搜索类别

start 开始的条数

url规则可以适用到图书电影搜索页面,后面的爬取也一样

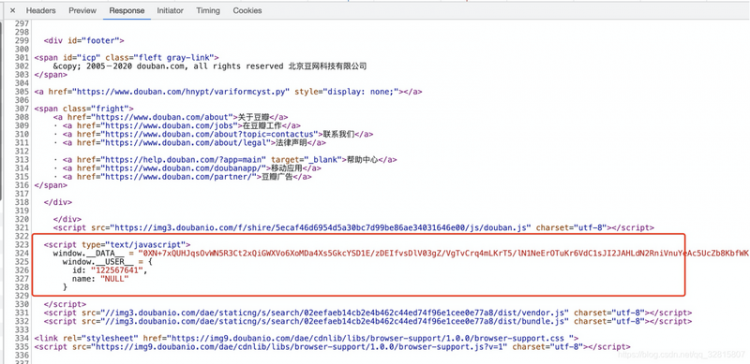

爬取后发现页面信息都无法获取,但是可以找到有个window.__DATA__猜测数据都被加密成了这串字符串

一轮百度发现有大佬把加密的js代码提取出来了!

于是直接给出大佬的链接豆瓣读书搜索页的window.__DATA__的解密

解决了这个问题其他的就很好爬取了

代码

完整代码见github仓库

提取出的js在third_party/main.js

class DoubanBookSearchSpider(scrapy.Spider):name = 'douban_book_search'

allowed_domains = ['douban.com']

def __init__(self,keyword=None,start=None,*args, **kwargs):

super(DoubanBookSearchSpider, self).__init__(*args, **kwargs)

self.keyword = keyword

self.start = start

self.start_urls.append(f'https://search.douban.com/book/subject_search?search_text={self.keyword}&cat=1001&start={self.start}')

def parse(self, response):

r = re.search('window.__DATA__ = "([^"]+)"', response.text).group(1)

# 导入js

file_path = pathlib.Path.cwd() / 'third_party/main.js'

with open(file_path, 'r', encoding='gbk') as f:

decrypt_js = f.read()

ctx = execjs.compile(decrypt_js)

data = ctx.call('decrypt', r)

for item in data['payload']['items']:

if item.get('rating', None):

cover_url = item['cover_url']

score = item['rating']['value']

score_num = item['rating']['count']

url = item['url']

abstract = item['abstract']

title = item['title']

id = item['id']

yield DouBanBookSearchItem(

cover_url=cover_url,

score=score,

score_num=score_num,

url=url,

abstract=abstract,

title=title,

id=id)

参考

爬虫框架Scrapy个人总结(详细)熟悉

架构概览

Scrapy爬虫框架,入门案例(非常详细)

豆瓣读书搜索页的window.__DATA__的解密

以上是 【Python】Scrapy 豆瓣搜索页爬虫 的全部内容, 来源链接: utcz.com/a/75538.html