如何快速批量将格式为.csv的股票交易数据导入DolphinDB

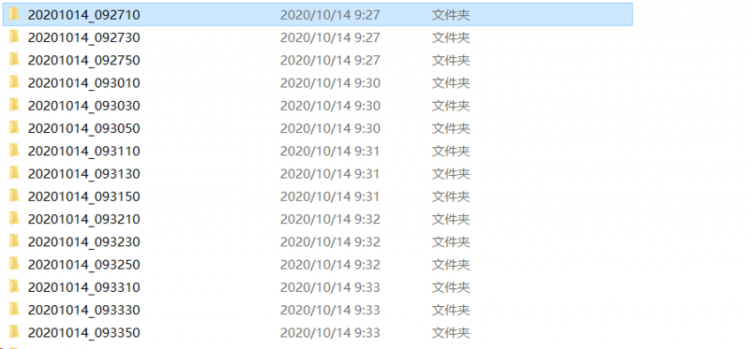

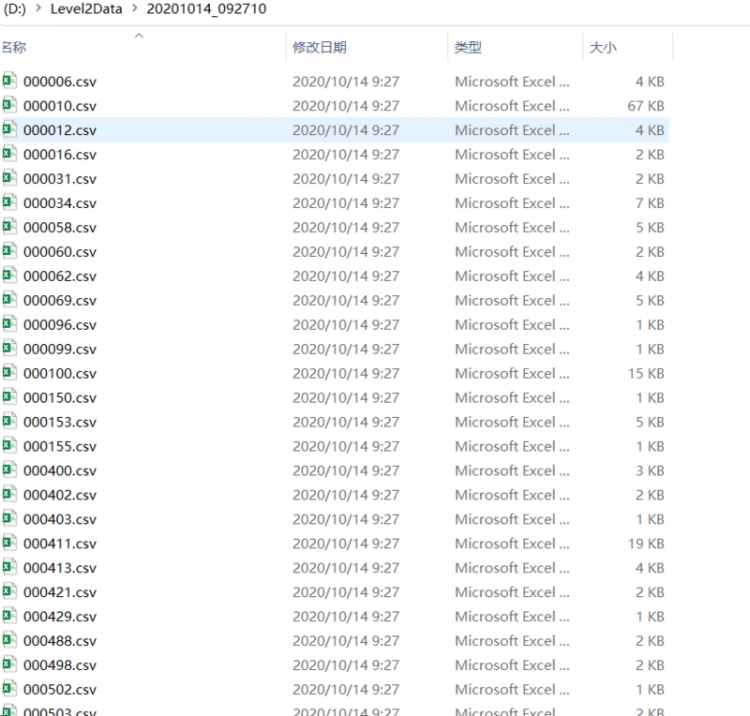

我有4000只格式为.csv的股票交易数据,想要快速写入到分布式表中,具体的文件储存方式如下:

如果用多线程或多进程,如何保证同一分区不被多个客户端同时占用?

回答

建议用loadTextEx,在dolphindb导入很快。若要更快,可以多线程,用ploop,但要保证多个线程不要写入同一个分区。

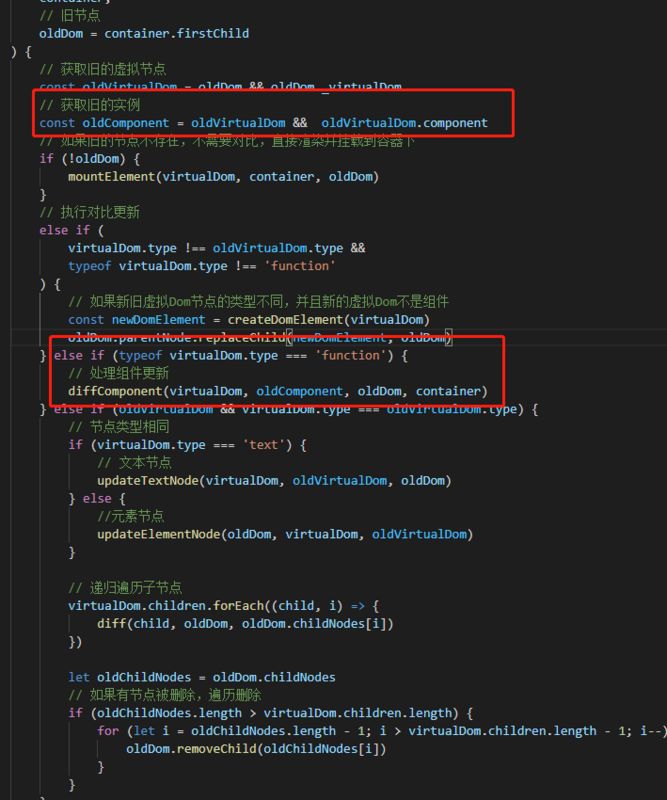

行情数据通常可用时间和产品标识两个维度来进行分区。要保证同一分区不被多个客户端同时占用,可让每个客户端写入不同的时间分区,比如对按天的数据库,可一个线程写入第一天的数据,第二个线程写入第二天的数据,其他天的依次类推。

产品标识维度的分区可采用哈希、范围、值、列表等多种方法。范围、值、列表写入不同分区显而易见,若是hash分区,需要用hashBucket函数获取某只股票所在分区,比如

hashBucket(`000890, 20)其中的20是按股票维度分区的分区数

以上是 如何快速批量将格式为.csv的股票交易数据导入DolphinDB 的全部内容, 来源链接: utcz.com/a/60014.html