大数据完全分布式配置(一)——基础环境配置、java、zookeeper、hadoop、jobHisoryServer

大数据集群配置系列一,完全分布式搭建hadoop,zookeeper。简单介绍jobhistory的配置流程。

准备工作

最小化安装master后,确定可以连接Xshell后。克隆出slave1、slave2,修改好网络配置并且确保三台虚拟机都在一个网关里,并能连接Xshell。

使用此教程前,确保已安装过伪分布式,有一定的linux基础。(还没走稳就想跑你想啥呢,老老实实安装伪分布去)

同时对三台虚拟机操作有两种方式:

1、使用Xshall中发送键到所有对话功能

2、在一台虚拟机中配置完毕后,使用scp命令将文件发送其他主机,如果没有进行过SSH免密配置,scp命令需要输入接收方主机密码,进行SSH免密配置后不需要再输密码,非常方便。

命名约定:

安装包提前拷贝在/usr/local/package中,三台虚拟机都有。

安装的软件都在/usr/local/下,配置的数据文件地址一般在软件安装文件夹中。

基础环境配置(master、slave1、slave2)

基础环境配置在三台主机上都要运行命令

修改主机名

分别在三台对应主机上修改,bash命令使改名及时生效

hostnamectl set-hostname masterhostnamectl set-hostname slave1

hostnamectl set-hostname slave2

bash

关闭防火墙

关闭防火墙

systemctl stop firewalld禁止防火墙开机自启

systemctl disable firewalld.service安装vim

由于最小化安装,默认自带的文件编辑是vi,没有代码高亮很不方便,于是安装vim

首先配置源

1、将源文件备份

cd /etc/yum.repos.d/ && mkdir backup && mv *repo backup/2、下载阿里源文件

curl -o /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-8.repo3、更新源里面的地址

sed -i -e "s|mirrors.cloud.aliyuncs.com|mirrors.aliyun.com|g " /etc/yum.repos.d/CentOS-*sed -i -e "s|releasever|releasever-stream|g" /etc/yum.repos.d/CentOS-*

4、生成缓存

yum clean all && yum makecache安装vim

yum install vimhosts添加映射

在文件中添加对应ip地址

vim /etc/hosts192.168.178.100 master

192.168.178.101 slave1

192.168.178.102 slave2

更改时区

timedatectl set-timezone Asia/ShanghaiSSH配置

首先生成密钥(master、slave1、slave2)

输入三个回车

ssh-keygen -t rsacd ~/.ssh

生成后把密钥分发,使三台主机之间可以互相连接

由于现在SSH没有完成,使用scp命令需要输入主机密码

# master将生成的密钥复制到authorized_keys文件中cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

# slave1和slave2的authorized_keys文件发送给master

# 下面两行命令分别slave1和slave2运行

scp id_rsa.pub root@master:~/.ssh/id_rsa.pub_s1 # slave1

scp id_rsa.pub root@master:~/.ssh/id_rsa.pub_s2 # slave2

# master上把密钥整合,再发放给slave1和slave2

# 下面命令都在master上运行

cat id_rsa.pub_s1 >> authorized_keys

cat id_rsa.pub_s2 >> authorized_keys

scp ~/.ssh/authorized_keys root@slave1:~/.ssh/

scp ~/.ssh/authorized_keys root@slave2:~/.ssh/

注:如果遇到权限错误,使用下面两个命令

# 修改权限,不一定会用到chmod 600 ~/.ssh/authorized_keys

chmod 700 -R ~/.ssh

查看三台主机的authorized_keys文件中有三台主机的密钥。

cat authorized_keys测试ssh是否成功,不需要再输密码,三台虚拟机都可以正常联通。

ssh masterssh slave1

ssh slave2

java配置(master、slave1、slave2)

进入安装包文件夹,解压java到/usr/local目录下

tar -xzf /usr/local/package/jdk-8u221-linux-x64.tar.gz -C /usr/local# 修改文件夹名字

mv /usr/local/jdk1.8.0_202 /usr/local/jdk

配置环境变量

vim /etc/profileexport JAVA_HOME=/usr/local/jdk

export PATH=$PATH:$JAVA_HOME/bin

source /etc/profile

或者/etc/profile中可以这样配置

export JAVA_HOME=/usr/local/jdkexport JRE_HOME=/usr/local/jdk/jre

export PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JRE_HOME/lib

检测是否安装

java -version分发文件(如果使用了Xshell发送到所有会话,则不用运行下面命令)

注:分发后记得 source /etc/profile

scp -r /usr/local/jdk root@slave1:/usr/local/scp -r /usr/local/jdk root@slave2:/usr/local/

scp -r /etc/profile root@slave1:/etc/

scp -r /etc/profile root@slave2:/etc/

zookeeper完全分布式配置(master、slave1、slave2)

解压安装,修改文件名

tar -zxf /usr/local/package/apache-zookeeper-3.7.0-bin.tar.gz -C /usr/local/mv /usr/local/apache-zookeeper-3.7.0-bin /usr/local/zookeeper

配置zookeeper系统环境变量($ZOOKEEPER_HOME)

vim /etc/profileexport ZOOKEEPER_HOME=/usr/local/zookeeper

export PATH=$PATH:$ZOOKEEPER_HOME/bin

source /etc/profile

修改zkServer.sh文件,加上JAVA_HOME

vim /usr/local/zookeeper/bin/zkServer.shexport JAVA_HOME=/usr/local/jdk

export PATH=$JAVA_HOME/bin:$PATH

修改配置文件zoo.cfg

zoo.cfg里面的东西不要删,增加修改就行

cd /usr/local/zookeepermkdir zkdata

mkdir zkdatalog

# 进入配置文件夹

cd conf

# 复制配置模板

cp zoo_sample.cfg zoo.cfg

# 编辑配置

vim zoo.cfg

# 修改其中

dataDir=/usr/local/zookeeper/zkdata

# 增加

dataLogDir=/usr/local/zookeeper/zkdatalog

server.1=master:2888:3888

server.2=slave1:2888:3888

server.3=slave2:2888:3888下面是zoo.cfg原文件

数据存储路径下创建myid

touch /usr/local/zookeeper/zkdata/myid分发

scp -r /usr/local/zookeeper root@slave1:/usr/local/scp -r /usr/local/zookeeper root@slave2:/usr/local/

scp -r /etc/profile root@slave1:/etc/

scp -r /etc/profile root@slave2:/etc/

source /etc/profile

修改myid,分别为123。

master中myid写入1,slave1中myid写入2,slave2中myid写入3

可以用cat /usr/local/zookeeper/zkdata/myid命令查看里面内容

# masterecho 1 > /usr/local/zookeeper/zkdata/myid

# slave1

echo 2 > /usr/local/zookeeper/zkdata/myid

# slave2

echo 3 > /usr/local/zookeeper/zkdata/myid

启动zookeeper服务(三台同时启动)

zkServer.sh start# 如果上面的不行用这个

/usr/local/zookeeper/bin/zkServer.sh start

验证是否成功

输入jps后三台主机都显示

[root@master zkdata]# jps6075 Jps

6031 QuorumPeerMain

查看三台主机状态,可以看到一台主机为leader,另外两台为follower。

[root@master zkdata]# zkServer.sh statusZooKeeper JMX enabled by default

Using config: /usr/local/zookeeper/bin/../conf/zoo.cfg

Client port found: 2181. Client address: localhost. Client SSL: false.

Mode: follower

[root@slave1 ~]# zkServer.sh status

ZooKeeper JMX enabled by default

Using config: /usr/local/zookeeper/bin/../conf/zoo.cfg

Client port found: 2181. Client address: localhost. Client SSL: false.

Mode: follower

[root@slave2 ~]# zkServer.sh status

ZooKeeper JMX enabled by default

Using config: /usr/local/zookeeper/bin/../conf/zoo.cfg

Client port found: 2181. Client address: localhost. Client SSL: false.

Mode: leader

常用命令

# 启动zkServer.sh start

# 重启

zkServer.sh restart

# 停止

zkServer.sh stop

# 查看状态

zkServer.sh status

# 这样启动就知道错误原因了

zkServer.sh start-foreground

debug

查看日志发现报错Cannot open channel to 3 at election address

将本机zoo.cfg中的ip改为0.0.0.0

如何查看日志?

会在当前终端目录下生成zookeeper.out文件

Hadoop完全分布式集群配置(master、slave1、slave2)

解压安装

tar -zxf /usr/local/package/hadoop-2.7.7.tar.gz -C /usr/local/mv /usr/local/hadoop-2.7.7 /usr/local/hadoop

配置Hadoop环境变量,注意生效

vim /etc/profileexport HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin

source /etc/profile

配置Hadoop运行环境JAVA_HOME

hadoop-env.sh 用来定义Hadoop运行环境相关的配置信息;

cd /usr/local/hadoop/etc/hadoopvim hadoop-env.sh

export JAVA_HOME=/usr/local/jdk

core-site.xml全局参数

设置全局参数,指定HDFS上NameNode地址为master,端口默认为9000

vim core-site.xml<property><name>fs.default.name</name>

<value>hdfs://master:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop/hadoopData/tmp</value>

</property>

hdfs-site.xml 定义名称节点、数据节点的存放位置、文本副本的个数、文件读取权限等;

vim hdfs-site.xml<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/hadoopData/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/hadoopData/data</value>

</property>

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

<property><name>dfs.namenode.secondary.http-address</name>

<value>master:9001</value>

</property>

<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

<property>

<name>dfs.datanode.use.datanode.hostnamedatanode</name>

<value>true</value>

</property>

设置YARN运行环境JAVA_HOME参数

vim yarn-env.shexport JAVA_HOME=/usr/local/jdk

yarn-site.xml 集群资源管理系统参数配置

设置YARN核心参数,指定ResourceManager进程所在主机为master,端口为18141

设置YARN核心参数,指定NodeManager上运行的附属服务为mapreduce_shuffle

vim yarn-site.xml<!--nomenodeManager获取数据的方式是shuffle--><property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!--配置shuffle,因为map和reduce之间有个shuffle过程,-->

<property>

<name>yarn.nademanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

<!-- 指定 ResourceManager 的地址-->

<property>

<name>yarn.resourcemanager.address</name>

<value>master:18040</value>

</property>

<!--调度器接口的地址。-->

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>master:18030</value>

</property>

<!--对每个rm-id,指定RM webapp对应的host-->

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>master:18088</value>

</property>

<!--对每个rm-id设置NodeManager连接的host-->

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>master:18025</value>

</property>

<!--对每个rm-id指定管理命令的host-->

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>master:18141</value>

</property>

mapred-site.xml MapReduce参数

设置计算框架参数,指定MR运行在yarn上

cp mapred-site.xml.template mapred-site.xmlvim mapred-site.xml

<property><name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.application.classpath</name>

<value>$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/*:$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/lib/*</value>

</property>

设置节点文件,要求master为主节点; slave1、slave2为子节点

echo master > master && echo slave1 > slaves && echo slave2 >> slaves分发文件

scp -r /usr/local/hadoop root@slave1:/usr/local/scp -r /usr/local/hadoop root@slave2:/usr/local/

scp -r /etc/profile root@slave1:/etc/

scp -r /etc/profile root@slave2:/etc/

source /etc/profile

文件系统格式化 (只在master)

建议格式化之前存快照,三个主机都存,方便后期修改

hadoop namenode -format启动Hadoop集群 (只在master)

/usr/local/hadoop/sbin/start-all.sh开启集群后在三台主机上运行jps命令查看输出

[root@master hadoop]# jps6672 SecondaryNameNode

6817 ResourceManager

7074 Jps

6483 NameNode

6031 QuorumPeerMain

[root@slave1 ~]# jps

2481 DataNode

2150 QuorumPeerMain

2586 NodeManager

2686 Jps

[root@slave2 ~]# jps

2582 NodeManager

2682 Jps

2156 QuorumPeerMain

2477 DataNode

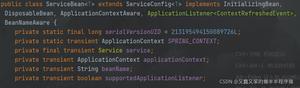

JobHistoryServer(master)

JobHistoryServer是hadoop自带的历史服务器,可以通过历史服务器查看已经运行完的Mapreduce作业记录,比如用了多少个Map、用了多少个Reduce、作业提交时间、作业启动时间、作业完成时间等信息。在后期学习mapreduce后,这个功能非常有用。

但是JobHistoryServer默认是不开启的,需要自己配置。但是不需要三台主机都配置,只在master主机配置就可以,流程如下。

首先master关闭集群

/usr/local/hadoop/sbin/stop-all.sh在 mapred-site.xml 文件中配置,添加下面内容

cd /usr/local/hadoop/etc/hadoopvim mapred-site.xml

<property><name>mapreduce.jobhistory.address</name>

<value>master:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>master:19888</value>

</property>

开启 jobhistoryserver

/usr/local/hadoop/sbin/mr-jobhistory-daemon.sh start historyserver开启集群

/usr/local/hadoop/sbin/start-all.sh最后使用jps命令查看服务是否都打开

[root@master hadoop]# jps7569 JobHistoryServer

8083 ResourceManager

8341 Jps

7737 NameNode

7931 SecondaryNameNode

6031 QuorumPeerMain

测试

运行mapreduce实例,结果为4.000000

cd /usr/local/hadoop/share/hadoop/mapreduce/hadoop jar hadoop-mapreduce-examples-2.7.7.jar pi 2 3

打开jobhistory WEB UI端口查看信息,可以看到刚刚运行的实例信息。

http://192.168.178.100:19888/以上是 大数据完全分布式配置(一)——基础环境配置、java、zookeeper、hadoop、jobHisoryServer 的全部内容, 来源链接: utcz.com/z/536446.html