Flume

flume简介

flume是一个分布式、可靠、和高可用的海量日志采集、和传输的系统。支持子啊日志系统

中定制各类数据发送方,用于收集数据;同时,flume提供对数据进行简单处理,并写道各种

数据接收方(比如文本、HDFS、Hbase等)的能力,flume的数据流由事件(Event)贯穿始终。

事件是flume的基本数据单位,它携带日志数据(字节数组形式)并且携带有头信息,这些

Event由Agent外部的source生成,当source捕获事件后会进行特定的格式化,然后,source会把事件推入(单个或多个)channel中。你可以把channel看作是一个缓冲区,它将保存事件直到sink处理完该事件。sink负责持久化日志或者把事件推向另一个source。

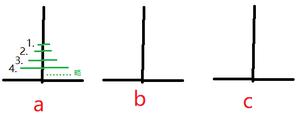

flume架构

flume 运行的核心是Agent。flume以agent为最小的独立运行单位,一个agent就是一个JVM。它是一个完整的数据数据收集工具,含有三个核心组件,分别是:

source、channel、sink。通过这些组件,Event可以从一个地方流向另一个地方,如下图所示

flume各组件的作用

Client:

Client生产数据,运行在一个独立的线程

Event:

一个数据单元,消息头和消息体组成,(Event可以是日志记录、avro对象等)

Flow:

event从源点到达目的点的迁移的抽象

Agent:

一个独立的flume进程,包含组件source、channel、sink。(agent使用JVM运行flume.每台机器运行一个agent,但是可以在一个agent中包含多个sources和sinks)

Source:

数据收集组件,(source从Client收集数据,传递给channel)

Source是数据的收集端,负责将数据捕获后进行特殊的格式化,将数据封装到事件(event) 里,然后将事件推入Channel中。 Flume提供了很多内置的Source, 支持 Avro, log4j, syslog 和 http post(body为json格式)。可以让应用程序同已有的Source直接打交道,如AvroSource

如果内置的Source无法满足需要, Flume还支持自定义Source。

Channel:

中转event的一个临时存储,保存由source组件传递过来的event。(channel连接source和sink,这个有点像一个队列)。

Channel是连接Source和Sink的组件,大家可以将它看做一个数据的缓冲区(数据队列),它可以将事件暂存到内存中也可以持久化到本地磁盘上, 直到Sink处理完该事件。介绍两个较为常用的Channel, MemoryChannel和FileChannel。

Sink:

从channel中读取并移除event,将event传递到flowPipline中的下一个agent(如果有的话)(sink从channel收集数据,运行在一个独立的线程)。

Sink从Channel中取出事件,然后将数据发到别处,可以向文件系统、数据库、 hadoop存数据, 也可以是其他agent的Source。在日志数据较少时,可以将数据存储在文件系统中,并且设定一定的时间间隔保存数据。

Flume数据流

Flume 的核心是把数据从数据源收集过来,再送到目的地。为了保证输送一定成功,在送到目的地之前,会先缓存数据,待数据真正到达目的地后,删除自己缓存的数据

Flume 传输的数据的基本单位是 Event,如果是文本文件,通常是一行记录,这也是事务的基本单位。 Event 从 Source,流向 Channel,再到 Sink,本身为一个 byte 数组,并可携带 headers 信息。 Event 代表着一个数据流的最小完整单元,从外部数据源来,向外部的目的地去。

值得注意的是,Flume提供了大量内置的Source、Channel和Sink类型。不同类型的Source,Channel和Sink可以自由组合。组合方式基于用户设置的配置文件,非常灵活。

比如:Channel可以把事件暂存在内存里,也可以持久化到本地硬盘上。Sink可以把日志写入HDFS, HBase,甚至是另外一个Source等等。Flume支持用户建立多级流,

也就是说,多个agent可以协同工作。

以上是 Flume 的全部内容, 来源链接: utcz.com/z/535584.html