网络爬虫是什么

爬虫" title="网络爬虫">网络爬虫(又称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。另外一些不常使用的名字还有蚂蚁、自动索引、模拟程序或者蠕虫。

下面我们来分析网络爬虫具体要做哪些核心工作:

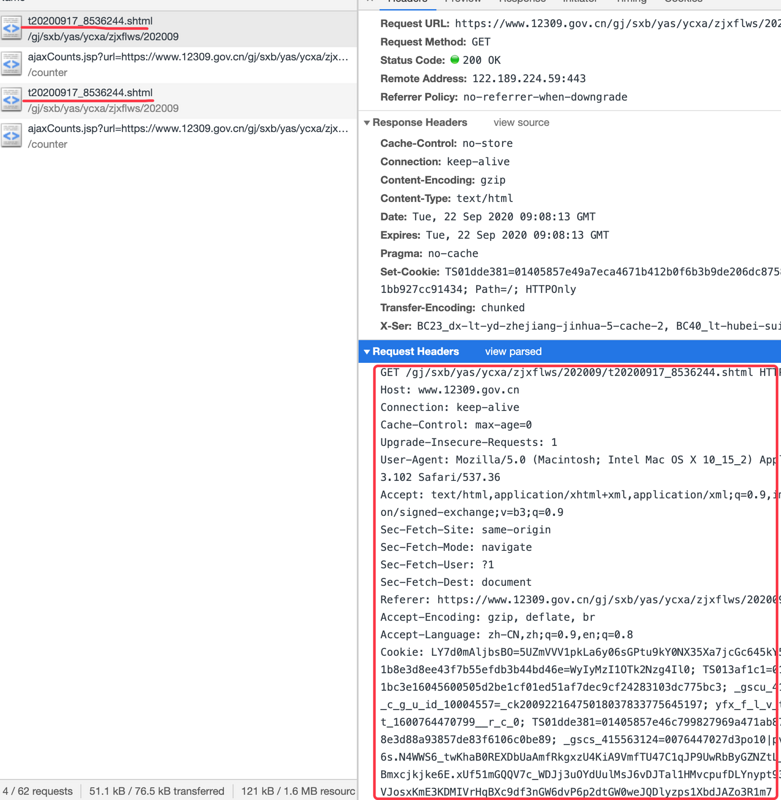

通过网络向指定的 URL 发送请求,获取服务器响应内容。

使用某种技术(如正则表达式、XPath 等)提取页面中我们感兴趣的信息。

高效地识别响应页面中的链接信息,顺着这些链接递归执行此处介绍的第 1、2、3 步;

使用多线程有效地管理网络通信交互。

如果直接使用 Python 内置的 urllib 和 re 模块是否能写出自己的网络爬虫呢?答案是肯定的,只是比较复杂。就像我们要从广州去韶关,走路可以去吗?答案是肯定的,只是比较麻烦。

下面继续分析网络爬虫的核心工作:

向 URL 发送请求,获取服务器响应内容。这个核心工作其实是所有网络爬虫都需要做的通用工作。一般来说,通用工作应该由爬虫框架来实现,这样可以提供更稳定的性能,开发效率更高。提取页面中我们感兴趣的信息。这个核心工作不是通用的!每个项目感兴趣的信息都可能有所不同,但使用正则表达式提取信息是非常低效的,原因是正则表达式的设计初衷主要是处理文本信息,而 HTML 文档不仅是文本文档,而且是结构化文档,因此使用正则表达式来处理 HTML 文档并不合适。使用 XPath 提取信息的效率要高得多。识别响应页面中的链接信息。使用正则表达式可以实现这个核心工作,但是效率太低,使用 XPath 会更高效。多线程管理:这个核心工作是通用的,应该由框架来完成。更多学习内容,请点击Python学习网。

以上是 网络爬虫是什么 的全部内容, 来源链接: utcz.com/z/522424.html