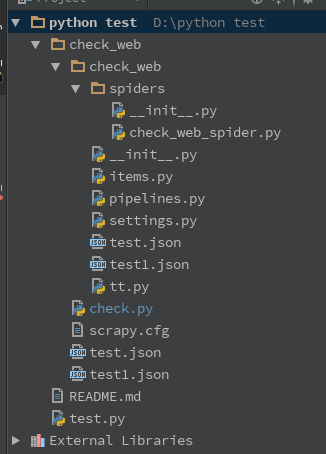

【linux】python 文件 运行 scrapy

写了一个scrapy,程序可以跑,没有任何问题。

爬下30个网站的body存入json文件,并且保存为test.json

如果test.json存在就保存到一个新建的test1.json

新建了一个python文件叫check.py,对比两个文件的hash值,如果有不一样,就发邮件到我邮箱。

在这个check.py内 有一句os.system(scrapy crawl xxxx)

问题来了。。 因为希望能定时运行,比如我在win上设置了定时执行计划,则每5分钟执行一次。这个是可以的。

有个问题和vps上一样,系统是centos 6。

比如随意在一个地方,用路径的方式打开这个check.py文件

python Documents/check_web/check.pyScrapy 1.1.1 - no active project

Unknown command: crawl

Use "scrapy" to see available commands

0s

10s

Traceback (most recent call last):

File "Documents/check_web/check.py", line 35, in <module>

f1 = open("./test.json", "rb")

IOError: [Errno 2] No such file or directory: './test.json'

check.py大致如下

def getJson():os.system('scrapy crawl check_web_sprider')

time.sleep(10)

def getHash(f):

line = f.readline()

hash = hashlib.md5()

while (line):

hash.update(line)

line = f.readline()

return hash.hexdigest()

def IsHashEqual(f1, f2):

str1 = getHash(f1)

str2 = getHash(f2)

return str1 == str2

if __name__ == '__main__':

f1 = open("./test.json", "rb")

f2 = open("./test1.json", "rb")

if (IsHashEqual(f1, f2) is False):

def _format_addr(s):

name, addr = parseaddr(s)

return formataddr(( \

Header(name, 'utf-8').encode(), \

addr.encode('utf-8') if isinstance(addr, unicode) else addr))

求问为什么会这样。。路径的方式就会显示

Scrapy 1.1.1 - no active projectUnknown command: crawl

但是如果我进入到check.py的路径下 然后

python check.py就没有任何问题。。爬虫也能正常工作。。

非常抱歉 文笔不太好 希望有人能看懂。。并且又知道如何解决。

thx!

check.py是在scrapy的工程目录下的。。

回答

路径问题,crawl 命令需要在工程目录中使用,同时,在其它路径中运行脚本,./test.json会保存在当前的工作目录中。

先得到绝对路径:

app_path = os.path.dirname(os.path.realpath(__file__))打开文件用:

f1 = open(os.path.join(app_path, "test.json"), "rb")运行 scapy 建议用 subprocess,试试加上 cwd=app_path,指定工作路径。

以上是 【linux】python 文件 运行 scrapy 的全部内容, 来源链接: utcz.com/a/84476.html