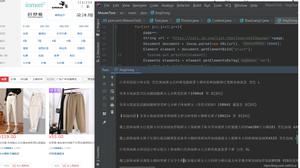

【Python】python 爬虫 ip 代理问题

self.s = requests.session()

# 代理服务器# 代理服务器

proxyHost = "http-dyn.abuyun.com"

proxyPort = "9020"

# 代理隧道验证信息

proxyUser = "HH30H1A522679P8D"

proxyPass = "74EF13F061719736"

proxyMeta = "http://%(user)s:%(pass)[email protected]%(host)s:%(port)s" % {

"host": proxyHost,

"port": proxyPort,

"user": proxyUser,

"pass": proxyPass,

}

self.proxies = {

"http": proxyMeta,

"https": proxyMeta,

}

response=self.s.get("http://httpbin.org/ip",proxies=self.proxies).text

print response 这里是打印的ip 访问的服务器是返回ip

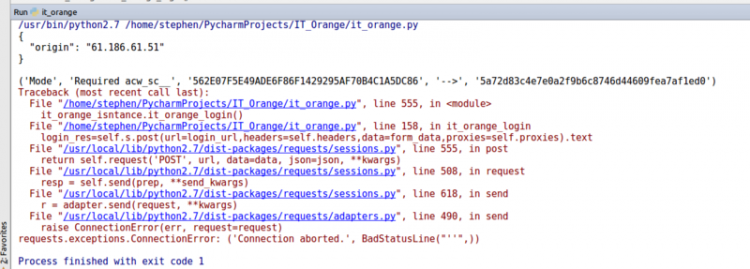

login_res=self.s.post(url=login_url,headers=self.headers,data=form_data,proxies=self.proxies).text 这是报错部分

我的ip 被封了 ,买了阿布云代理 但是访问网站 还是不行,跪求大神指教,难道买的ip 不是高匿?用阿布云请求 返回来ip 我打印出来的 和本机不一样

回答

你的帐号需要付款

使用未被封ip的机器,分别使用代理和不用代理测试链接,判断是否是代理的问题

如果都不行的话,检查请求过程的代码

如果使用代理不行的话,检测代理是否可用或是否添加特殊的header信息。

如果都可以的话,但是被封的ip使用代理不可以,说明你的实际ip会被检测到。

通过你的代理访问一下https://httpbin.org/get?show_...,看看请求是什么样子的,是不是被代理添加了一些代理特定的头部

代理是高匿名的,但是你代码完全没有headers,对方服务器可以马上发现你是爬虫

以上是 【Python】python 爬虫 ip 代理问题 的全部内容, 来源链接: utcz.com/a/80897.html