验证码一直是爬虫的老大难!通过此方法可识别90%的网站!不吹牛

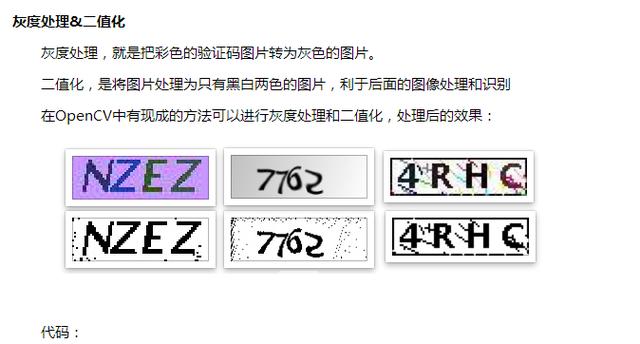

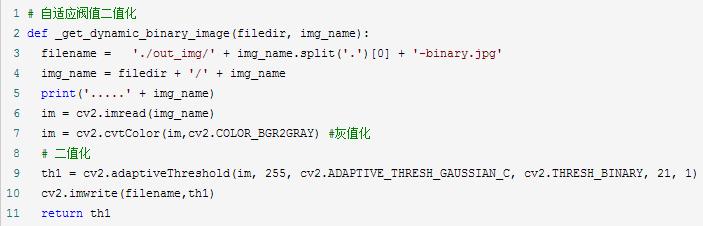

这6个步骤中前三个步骤是基本的,4或者5可根据实际情况选择是否需要,并不一定切割验证码,识别率就会上升很多有时候还会下降

这篇博客不涉及训练字体库的内容,请自行搜索。同样也不讲解基础的语法。

用到的几个主要的python库: Pillow(python图像处理库)、OpenCV(高级图像处理库)、pytesseract(识别库)

进群:548377875 即可获取数十套PDF哦!

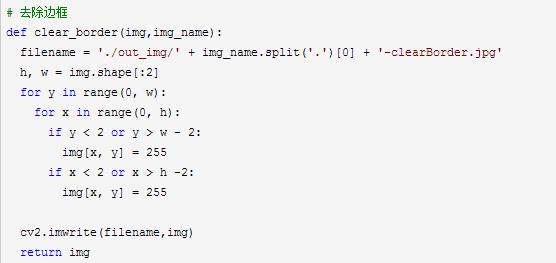

去除边框

如果验证码有边框,那我们就需要去除边框,去除边框就是遍历像素点,找到四个边框上的所有点,把他们都改为白色,我这里边框是两个像素宽

注意:在用OpenCV时,图片的矩阵点是反的,就是长和宽是颠倒的

代码:

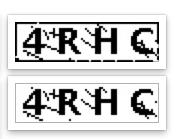

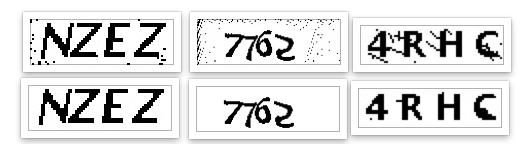

效果:

降噪

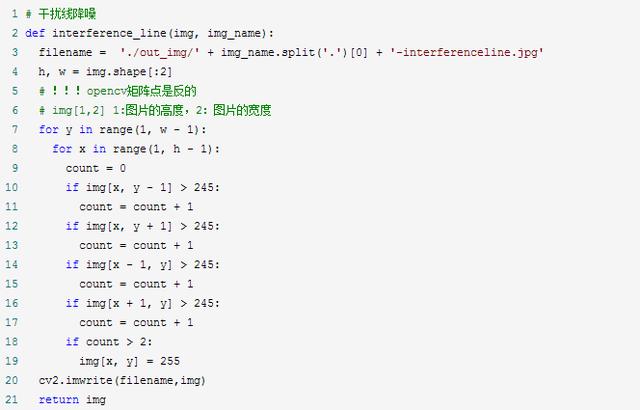

降噪是验证码处理中比较重要的一个步骤,我这里使用了点降噪和线降噪

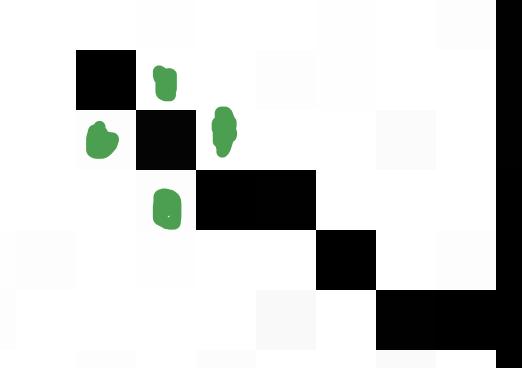

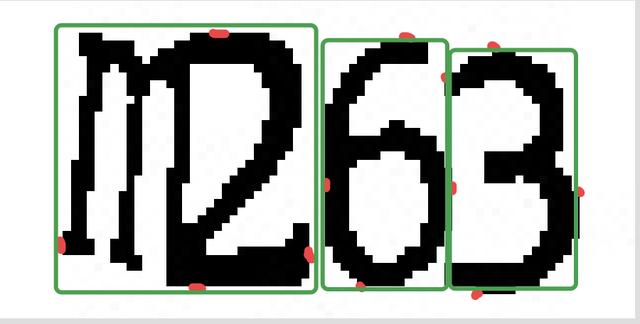

线降噪的思路就是检测这个点相邻的四个点(图中标出的绿色点),判断这四个点中是白点的个数,如果有两个以上的白色像素点,那么就认为这个点是白色的,从而去除整个干扰线,但是这种方法是有限度的,如果干扰线特别粗就没有办法去除,只能去除细的干扰线

代码:

点降噪的思路和线降噪的差不多,只是会针对不同的位置检测的点不一样,注释写的很清楚了

代码:

# 点降噪def interference_point(img,img_name, x = 0, y = 0):

"""

9邻域框,以当前点为中心的田字框,黑点个数

:param x:

:param y:

:return:

"""

filename = './out_img/' + img_name.split('.')[0] + '-interferencePoint.jpg'

# todo 判断图片的长宽度下限

cur_pixel = img[x,y]# 当前像素点的值

height,width = img.shape[:2]

for y in range(0, width - 1):

for x in range(0, height - 1):

if y == 0: # 第一行

if x == 0: # 左上顶点,4邻域

# 中心点旁边3个点

sum = int(cur_pixel)

+ int(img[x, y + 1])

+ int(img[x + 1, y])

+ int(img[x + 1, y + 1])

if sum <= 2 * 245:

img[x, y] = 0

elif x == height - 1: # 右上顶点

sum = int(cur_pixel)

+ int(img[x, y + 1])

+ int(img[x - 1, y])

+ int(img[x - 1, y + 1])

if sum <= 2 * 245:

img[x, y] = 0

else: # 最上非顶点,6邻域

sum = int(img[x - 1, y])

+ int(img[x - 1, y + 1])

+ int(cur_pixel)

+ int(img[x, y + 1])

+ int(img[x + 1, y])

+ int(img[x + 1, y + 1])

if sum <= 3 * 245:

img[x, y] = 0

elif y == width - 1: # 最下面一行

if x == 0: # 左下顶点

# 中心点旁边3个点

sum = int(cur_pixel)

+ int(img[x + 1, y])

+ int(img[x + 1, y - 1])

+ int(img[x, y - 1])

if sum <= 2 * 245:

img[x, y] = 0

elif x == height - 1: # 右下顶点

sum = int(cur_pixel)

+ int(img[x, y - 1])

+ int(img[x - 1, y])

+ int(img[x - 1, y - 1])

if sum <= 2 * 245:

img[x, y] = 0

else: # 最下非顶点,6邻域

sum = int(cur_pixel)

+ int(img[x - 1, y])

+ int(img[x + 1, y])

+ int(img[x, y - 1])

+ int(img[x - 1, y - 1])

+ int(img[x + 1, y - 1])

if sum <= 3 * 245:

img[x, y] = 0

else: # y不在边界

if x == 0: # 左边非顶点

sum = int(img[x, y - 1])

+ int(cur_pixel)

+ int(img[x, y + 1])

+ int(img[x + 1, y - 1])

+ int(img[x + 1, y])

+ int(img[x + 1, y + 1])

if sum <= 3 * 245:

img[x, y] = 0

elif x == height - 1: # 右边非顶点

sum = int(img[x, y - 1])

+ int(cur_pixel)

+ int(img[x, y + 1])

+ int(img[x - 1, y - 1])

+ int(img[x - 1, y])

+ int(img[x - 1, y + 1])

if sum <= 3 * 245:

img[x, y] = 0

else: # 具备9领域条件的

sum = int(img[x - 1, y - 1])

+ int(img[x - 1, y])

+ int(img[x - 1, y + 1])

+ int(img[x, y - 1])

+ int(cur_pixel)

+ int(img[x, y + 1])

+ int(img[x + 1, y - 1])

+ int(img[x + 1, y])

+ int(img[x + 1, y + 1])

if sum <= 4 * 245:

img[x, y] = 0

cv2.imwrite(filename,img)

return img

效果:

其实到了这一步,这些字符就可以识别了,没必要进行字符切割了,现在这三种类型的验证码识别率已经达到50%以上了

字符切割

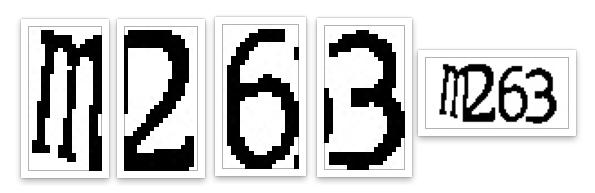

字符切割通常用于验证码中有粘连的字符,粘连的字符不好识别,所以我们需要将粘连的字符切割为单个的字符,在进行识别

字符切割的思路就是找到一个黑色的点,然后在遍历与他相邻的黑色的点,直到遍历完所有的连接起来的黑色的点,找出这些点中的最高的点、最低的点、最右边的点、最左边的点,记录下这四个点,认为这是一个字符,然后在向后遍历点,直至找到黑色的点,继续以上的步骤。最后通过每个字符的四个点进行切割

图中红色的点就是代码执行完后,标识出的每个字符的四个点,然后就会根据这四个点进行切割(图中画的有些误差,懂就好)

但是也可以看到,m2是粘连的,代码认为他是一个字符,所以我们需要对每个字符的宽度进行检测,如果他的宽度过宽,我们就认为他是两个粘连在一起的字符,并将它在从中间切割

确定每个字符的四个点代码:

def cfs(im,x_fd,y_fd):'''用队列和集合记录遍历过的像素坐标代替单纯递归以解决cfs访问过深问题

'''

# print('**********')

xaxis=[]

yaxis=[]

visited =set()

q = Queue()

q.put((x_fd, y_fd))

visited.add((x_fd, y_fd))

offsets=[(1, 0), (0, 1), (-1, 0), (0, -1)]#四邻域

while not q.empty():

x,y=q.get()

for xoffset,yoffset in offsets:

x_neighbor,y_neighbor = x+xoffset,y+yoffset

if (x_neighbor,y_neighbor) in (visited):

continue # 已经访问过了

visited.add((x_neighbor, y_neighbor))

try:

if im[x_neighbor, y_neighbor] == 0:

xaxis.append(x_neighbor)

yaxis.append(y_neighbor)

q.put((x_neighbor,y_neighbor))

except IndexError:

pass

# print(xaxis)

if (len(xaxis) == 0 | len(yaxis) == 0):

xmax = x_fd + 1

xmin = x_fd

ymax = y_fd + 1

ymin = y_fd

else:

xmax = max(xaxis)

xmin = min(xaxis)

ymax = max(yaxis)

ymin = min(yaxis)

#ymin,ymax=sort(yaxis)

return ymax,ymin,xmax,xmin

def detectFgPix(im,xmax):

'''搜索区块起点

'''

h,w = im.shape[:2]

for y_fd in range(xmax+1,w):

for x_fd in range(h):

if im[x_fd,y_fd] == 0:

return x_fd,y_fd

def CFS(im):

'''切割字符位置

'''

zoneL=[]#各区块长度L列表

zoneWB=[]#各区块的X轴[起始,终点]列表

zoneHB=[]#各区块的Y轴[起始,终点]列表

xmax=0#上一区块结束黑点横坐标,这里是初始化

for i in range(10):

try:

x_fd,y_fd = detectFgPix(im,xmax)

# print(y_fd,x_fd)

xmax,xmin,ymax,ymin=cfs(im,x_fd,y_fd)

L = xmax - xmin

H = ymax - ymin

zoneL.append(L)

zoneWB.append([xmin,xmax])

zoneHB.append([ymin,ymax])

except TypeError:

return zoneL,zoneWB,zoneHB

return zoneL,zoneWB,zoneHB

分割粘连字符代码:

# 切割的位置im_position = CFS(im)

maxL = max(im_position[0])

minL = min(im_position[0])

# 如果有粘连字符,如果一个字符的长度过长就认为是粘连字符,并从中间进行切割

if(maxL > minL + minL * 0.7):

maxL_index = im_position[0].index(maxL)

minL_index = im_position[0].index(minL)

# 设置字符的宽度

im_position[0][maxL_index] = maxL // 2

im_position[0].insert(maxL_index + 1, maxL // 2)

# 设置字符X轴[起始,终点]位置

im_position[1][maxL_index][1] = im_position[1][maxL_index][0] + maxL // 2

im_position[1].insert(maxL_index + 1, [im_position[1][maxL_index][1] + 1, im_position[1][maxL_index][1] + 1 + maxL // 2])

# 设置字符的Y轴[起始,终点]位置

im_position[2].insert(maxL_index + 1, im_position[2][maxL_index])

# 切割字符,要想切得好就得配置参数,通常 1 or 2 就可以

cutting_img(im,im_position,img_name,1,1)

切割粘连字符代码:

def cutting_img(im,im_position,img,xoffset = 1,yoffset = 1):filename = './out_img/' + img.split('.')[0]

# 识别出的字符个数

im_number = len(im_position[1])

# 切割字符

for i in range(im_number):

im_start_X = im_position[1][i][0] - xoffset

im_end_X = im_position[1][i][1] + xoffset

im_start_Y = im_position[2][i][0] - yoffset

im_end_Y = im_position[2][i][1] + yoffset

cropped = im[im_start_Y:im_end_Y, im_start_X:im_end_X]

cv2.imwrite(filename + '-cutting-' + str(i) + '.jpg',cropped)

效果:

识别

识别用的是typesseract库,主要识别一行字符和单个字符时的参数设置,识别中英文的参数设置,代码很简单就一行,我这里大多是filter文件的操作

代码:

# 识别验证码cutting_img_num = 0

for file in os.listdir('./out_img'):

str_img = ''

if fnmatch(file, '%s-cutting-*.jpg' % img_name.split('.')[0]):

cutting_img_num += 1

for i in range(cutting_img_num):

try:

file = './out_img/%s-cutting-%s.jpg' % (img_name.split('.')[0], i)

# 识别字符

str_img = str_img + image_to_string(Image.open(file),lang = 'eng', config='-psm 10') #单个字符是10,一行文本是7

except Exception as err:

pass

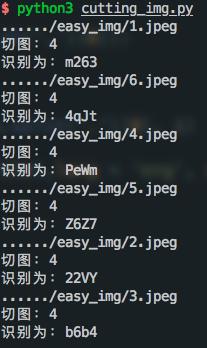

print('切图:%s' % cutting_img_num)

print('识别为:%s' % str_img)

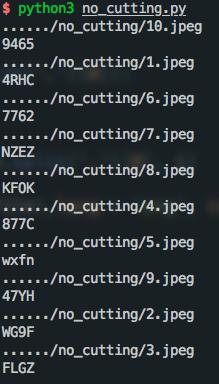

最后这种粘连字符的识别率是在30%左右,而且这种只是处理两个字符粘连,如果有两个以上的字符粘连还不能识别,但是根据字符宽度判别的话也不难,有兴趣的可以试一下

无需切割字符识别的效果:

需要切割字符的识别效果:

这种只是能够识别简单验证码,复杂的验证码还要靠大家了

以上是 验证码一直是爬虫的老大难!通过此方法可识别90%的网站!不吹牛 的全部内容, 来源链接: utcz.com/a/52123.html